COURS CARTE A PUCE

Historique, concepts, sécurité des cartes, TP

© Pascal Chour, 1989 - 2025

Mise à jour, mai 2025, 10ème édition indice 9

Le logiciel PCCAM permet de réaliser les TP décrits dans ce cours

|

AVERTISSEMENT Le présent cours est destiné à des fins pédagogiques. Ses lecteurs s'engagent à ne pas utiliser les informations qu'il contient à des fins illicites. Ce cours relève de la seule responsabilité personnelle de son auteur et ne peut engager son employeur ou toute institution de formation, qu'elle soit privée ou publique, qui l'emploie. |

SOMMAIRE DETAILLE

PREAMBULE

Ce document est la mise à jour d'un cours que je donnais dans les années 1980 sur les cartes à puce et vient compléter la (déjà) abondante documentation sur le sujet.

Il vise à faire le point sur la technologie des cartes à puce, leurs applications, leur sécurité, et tente de montrer comment le marché à évolué depuis, non pas sa création (et oui, il y a une histoire avant celle que je raconte. Voir la partie bibliographie juste après), mais au moins, depuis une période suffisamment lointaine pour que l'on puisse parler de « vieillerie » ce qui après tout, est le thème de ce site.

Toutefois, les plus jeunes lecteurs qui ne sont pas forcément (encore) intéressés par l'histoire trouveront également de quoi se former aux cartes actuelles avec en prime, un petit logiciel qui leur permettra de faire quelques expérimentations.

Dernier point : certains chapitres traitent d'anciens projets qui reposent en paix aujourd'hui (c'est tout ce qu'on peut leur souhaiter). Pour les plus concernés, je les ai mis en annexe. Néanmoins, j'ai tenu à conserver les exemples parlant de projets tels que les cartes PASTEL ou la Télécarte ou les premières cartes bancaires françaises car ils permettent de se rappeler que de nombreuses expérimentations avaient été faites dès les années 80, donnant lieu à des projets d'envergure, et aussi parfois, à des échecs retentissants. La lecture de ces chapitres devrait permettre d'éviter à certains de réinventer la roue (et de perdre du temps et surtout, d'en faire perdre aux autres, mais là, c'est juste un rêve).

Quelques liens sur des documents à lire pour compléter ce cours

- Histoire secrète de la carte à puce, Roland Moreno dans son style toujours très libre...

- Histoire de la carte à puce du point de vue d'un cryptologue, Louis Guillou

- Cartes à puce, Michel Ugon dans « Techniques de l'ingénieur ».

- La carte à puce, Pascal Urien (sachant que ce cours est mis à jour régulièrement et que la version en lien n'est peut-être pas la dernière)

- Super Dupont sauvant l'industrie française de la carte (il faut bien se détendre un peu). J'espère que Gotlib me pardonnera ce détournement (sinon, je le vire (le détournement évidemment)).

GENERALITES SUR LES CARTES

Depuis les années 1980, la carte à puce s'est imposée dans notre quotidien, qu'il s'agisse de cartes bancaires, dans le passé de Télécartes, des cartes SIM de nos téléphones portables, etc.

Elle a donné naissance à une importante activité économique qui touche la fabrication de composants électroniques, le développement de logiciels, les processus de personnalisation et de distribution, les machines outils, les périphériques, le développement d'applications, les tests de conformité, les tests de sécurité, etc.

Mais surtout, cette invention a créé un objet de sécurité dans le domaine des technologies de l'information dont la sécurité intrinsèque est sans commune mesure avec tout ce que l'on peut faire par ailleurs. Le fait est paradoxalement peu connu :

- Le grand public n'a aucune raison de faire ce genre de comparaison.

- Beaucoup d'experts en sécurité ne connaissent pas les spécificités de ces objets qu'ils assimilent à un système informatique comme n'importe quel autre.

Un des objectifs de ce cours est de montrer en quoi cet objet est particulier du point de vue de la sécurité.

Vocabulaire

Dans les années 1980, on parlait en France de « cartes à mémoire » pour désigner l'objet composé d'une carte plastique au format « carte bancaire » et d'un composant électronique inséré dans l'épaisseur de la carte.

Assez rapidement, il est apparu que le terme était impropre. Il a même été à l'origine d'une confusion lorsque le groupement INTAMIC (dont Eurosmart doit être un lointain successeur) a fait réaliser une étude de marché internationale au milieu des années 1980.

En particulier, les japonais contestaient l'intérêt de ce dispositif au prétexte que les cartes à mémoire étaient déjà largement répandues, par exemple, pour permettre le chargement des polices de caractères dans les imprimantes... Si le débat devait avoir lieu aujourd'hui, on parlerait probablement de clés USB.

Dans ces deux exemples, on a bien un dispositif électronique communicant mais pas de sécurité. Sans compter qu'il existe des tas d'autres exemples où l'on a bien des cartes, de la mémoire (une bande magnétique par exemple) mais pas de composant électronique du tout.

Le terme « carte à puce » s'est ensuite susbtitué à la « carte à mémoire » afin de mieux faire ressortir le caractère électronique de l'objet. Il était encore utilisé en France dans les années 2010. S'il est plus juste que le précédent, il fait quand même oublier l'essentiel.

La carte, dans ses différents facteurs de forme, n'est qu'un accident de parcours dans l'utilisation de cette technologie. Certes, elle l'a popularisée. Mais ce qui compte, ce n'est pas le support de la puce, c'est la puce elle-même dont on pourrait résumer les particularités de la façon suivante :

Il s'agit d'un composant électronique communicant,

réalisant des fonctions logiques

et destiné à mettre en œuvre de façon active (par lui-même)

des fonctionnalités de sécurité.

Par rapport à cette définition, le terme « carte à puce » pose deux problèmes : il passe sous silence l'aspect sécurité et laisse à penser que cette technologie est associée à un facteur de forme.

C'est ainsi que certains ont pu entretenir la confusion entre les les puces RFID (Radio-Frequency Identification) et les cartes à puce sans contact. Les puces RFID existent depuis les années 1980. A l'époque, elles utilisaient une pile. Avec le temps, elles ont tiré leur alimentation du champ électromagnétique utilisé pour communiquer avec elles. On les trouve dans certains systèmes de contrôle d'accès physiques (non sécurisés !), dans des systèmes d'identification d'animaux, de containers, de produits de grande consommation, etc. La différence entre les puces des RFID qui se retrouvent parfois dans des cartes et les « cartes à puce » porte encore une fois sur la sécurité : la plupart des RFID n'ont aucune vocation sécuritaire. Cela pourrait changer (il existe de nombreux projets pour réaliser des RFID sécurisés) mais dans ce cas, on retombera probablement sur les technologies de la cartes à puce.

Le terme « carte à microcircuit » ou plus restrictif, « carte à microprocesseur » est également utilisé, en particulier, dans la normalisation. Il est à peine plus précis que le terme « carte à puce » mais a permis un temps de distinguer plus ou moins deux technologies :

- la carte en logique câblée (carte à microcircuit) qui ne comporte généralement qu'une circuiterie logique destinée à réaliser des fonctions basiques

- et la carte à microprocesseur qui comporte un ou plusieurs processeurs réalisant des fonctions complexes.

Mais là encore, rien sur la sécurité.

Le terme le plus approprié serait probablement « carte à microcontrôleur sécurisé » ou « carte à microcircuit sécurisé » mais c'est un peu long.

Le terme qui a tendance à s'imposer depuis les années 2000 est celui d'« élément sécurisé » (ou en anglais, secure element). Il s'agit presque d'un retour aux origines lorsque l'on considère l'intitulé du brevet de la carte Bull-CP8. Il décrit enfin ce qui fait une particularité importante du dispositif (la sécurité) et ce, sans l'associer à un facteur de forme (carte) ni à une technologie particulière. On peut donc intellectuellement envisager son utilisation dans d'autres choses que des cartes. Je devrais dire « de nouveau envisager » puisqu'à l'origine, les premières idées d'applications n'étaient pas forcément associées aux cartes et l'on trouvait des équipements intégrant des composants de « cartes à puce » en boitier DIL comme par exemple, une carte d'extension de Bull-CP8 utilisée en coprocesseur sécurisé pour les ordinateurs compatibles IBM-PC.

A la fin des années 1980, mon cours commençait par faire la différence entre « carte à mémoire » et « carte à microprocesseur » (CAM dans la suite du document). Je ne l'ai pas conservée dans le corps de ce document mais pour ceux que cela intéresse, vous trouverez en annexe quelques informations sur certaines technologies mise en oeuvre à l'époque dans les « cartes à mémoire » (en particulier, les cartes à piste et les cartes laser).

Par contre, j'ai tenu à conserver une brève description des cartes en logiques câblées qui ont été les précurseurs de la carte à microprocesseur

Les cartes en logique câblée

En 1973, la société Nord Américaine Intel conçoit et réalise les premières mémoires permanentes électroniques inscriptibles électriquement (EPROM 1702) ainsi que le premier micro-processeur (8008. Ok, pour les pinailleurs, il y avait eu le 4004 un peu avant mais on ne jouait pas tout à fait dans la même cour).

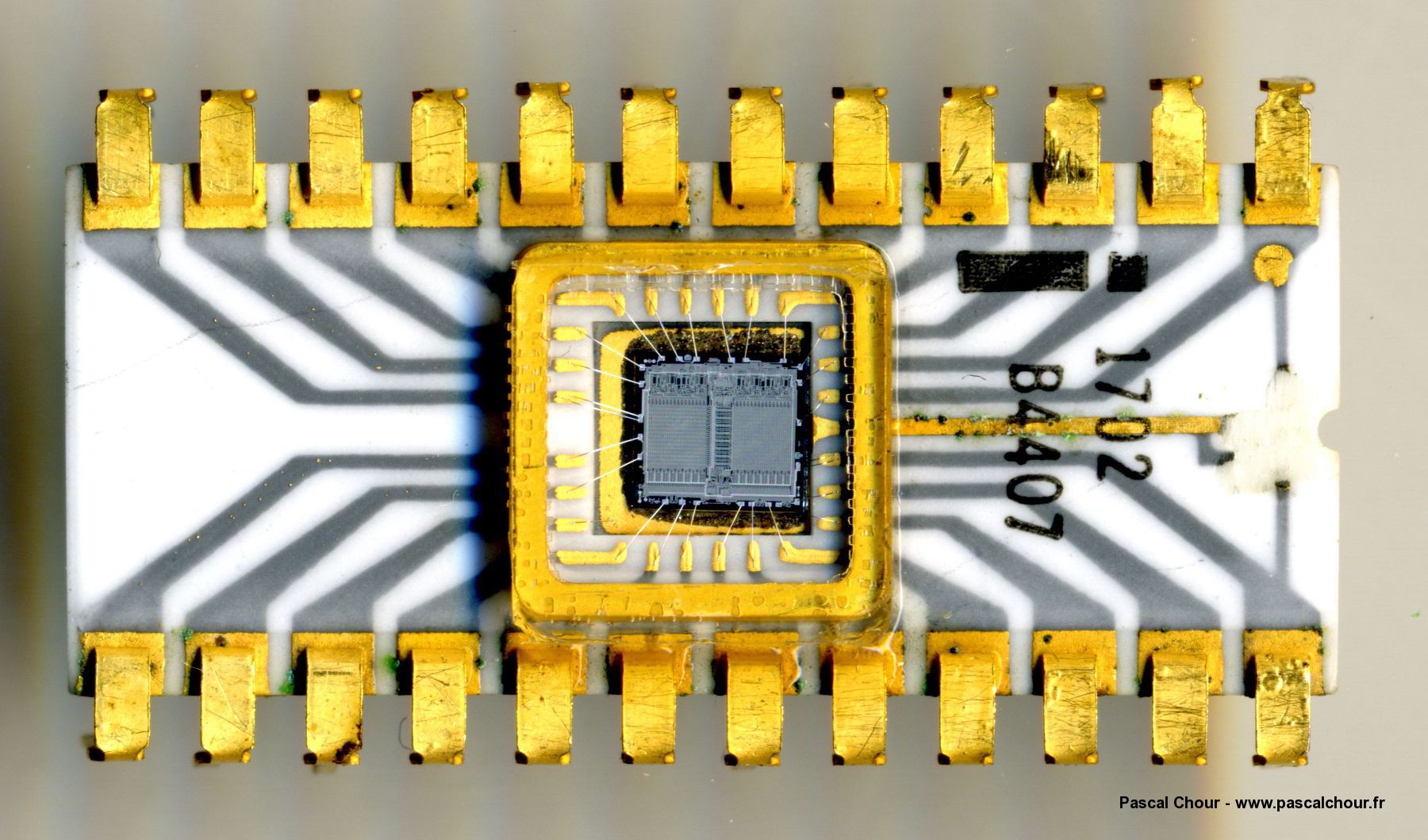

EPROM 1702 de mon stock personnel. Cliquez pour agrandir.

En 1974, le Français Roland Moréno (décédé le 29 avril 2012 à 66 ans) dépose une série de brevets dont un concernant un « système pour transférer des données de manière personnelle et confidentielle au moyen d'objets portatifs électroniques indépendants » et crée la société Innovatron (les autres brevets porteront sur des mécanismes de protection de ces données et des moyens de communication du dispositif avec l'environnement). A l'origine, on peut remarquer que rien ne liait particulièrement ce système électronique avec la carte plastique au format bancaire. Il en est toujours de même aujourd'hui mais c'est sous cette forme qu'il a été le plus répandu et le plus connu pendant un temps.

Schématiquement, la carte en logique câblée peut se décomposer en deux sous-ensembles. D'une part, une mémoire inscriptible électriquement, d'autre part, un automate en logique câblée chargé de gérer les communications avec l'environnement et de contrôler l'accès à la mémoire. Les cartes F256 ayant servi à la Télécarte française ou la MZ9K, toutes les deux des années 1980 et distribuées à l'époque par la société Schlumberger (ou plus tard, par Gemplus sous les références GPM256, GPM416, GPM896) en sont des exemples. Cette technologie apporte une certaine « intelligence » à la carte.

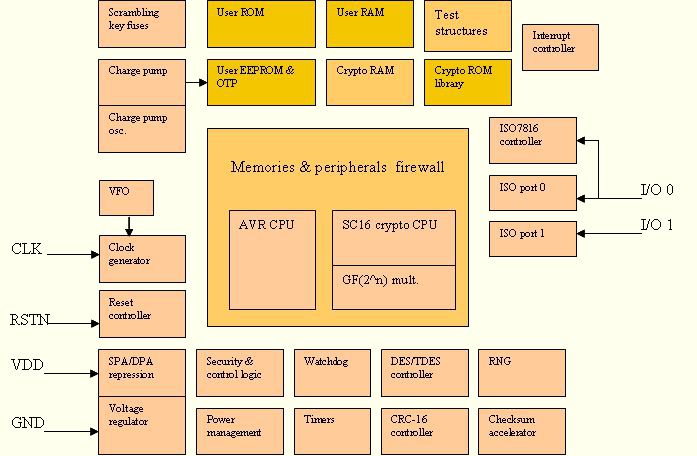

Carte à micro-processeur

Avec les cartes à microprocesseurs, on assiste à un véritable saut technologique et fonctionnel. Ce sont ces types de cartes qui permettent de réaliser des systèmes d'identification et d'authentification offrant un très grand niveau de sécurité. Celles-ci ont été inventées par la société Bull et le brevet a été déposé en 1978 (Michel Ugon). Comme on le remarque, la carte la plus courante n'est pas réellement l'invention de Roland Moréno.

La CAM de l'époque se composait d'un micro-processeur, d'une mémoire ROM (Read Only Memory) contenant le programme d'application de la carte, d'une mémoire vive (RAM Random Access Memory), et des systèmes logiques permettant de réaliser un micro-ordinateur complet. A tout cela, on ajoutait une mémoire de type EPROM dont le rôle était de mémoriser de façon permanente des informations durant la vie de la carte.

Le petit nom de l'époque désignant ce microcontrôleur spécifique était MAM pour Micro-calculateur Autoprogrammable Monolythique (ou SPOM en anglais pour Self Programmable One-chip Microcomputer).

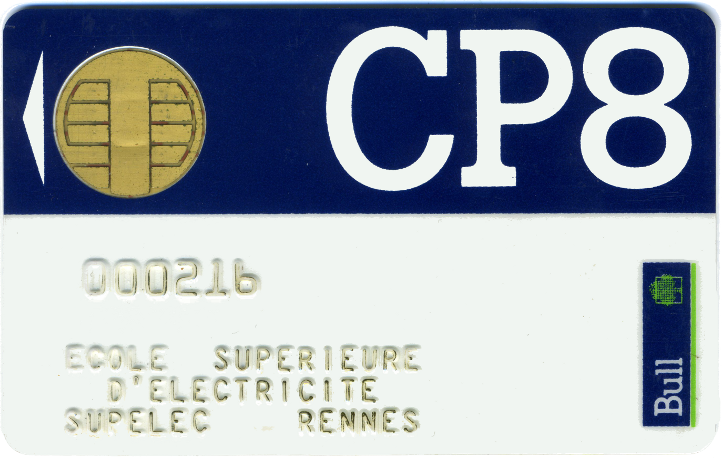

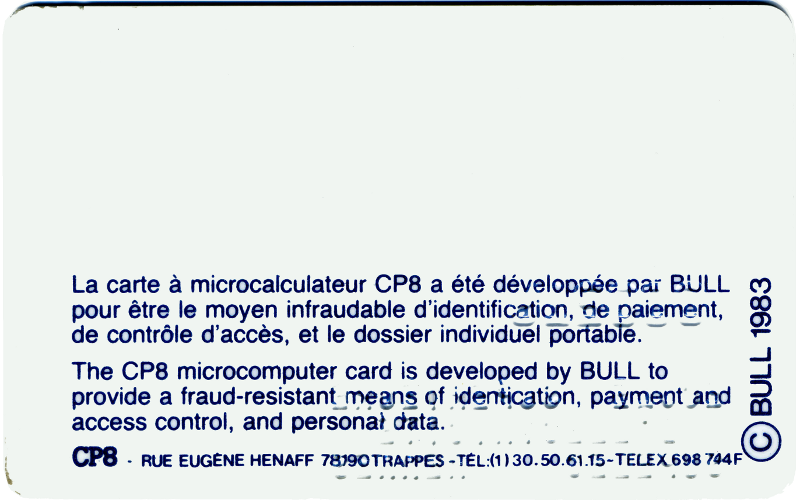

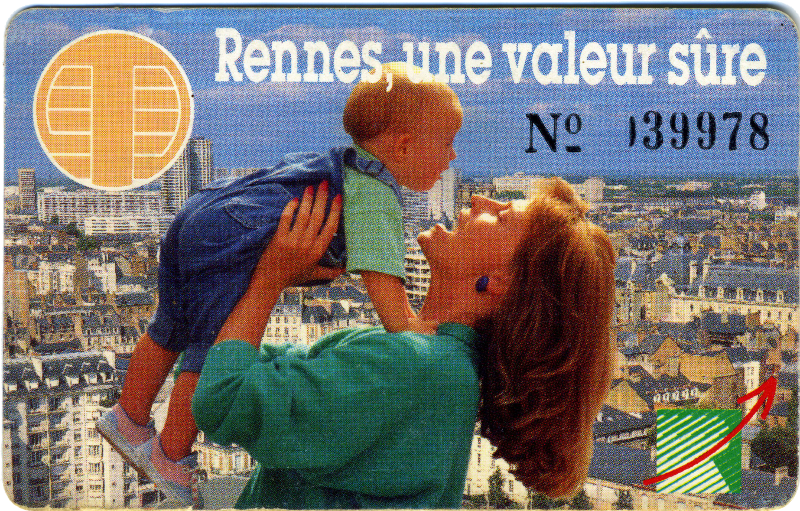

A priori, rien ne la distinguait beaucoup d'un microcontrôleur traditionnel (comme le Intel 8751 par exemple). C'est pour cette raison que le brevet sera longtemps contesté (par exemple, par Schlumberger qui était alors le leader mondial dans la fabrication des cartes... en logique câblée). Toutefois, le brevet de Bull-CP8 (CP8 pour Circuit portatif des années 1980 d'après Roland Moreno) finira par s'imposer car ce qui distingue cette carte (et en pratique, ce concept) d'un banal microcontrôleur est la sécurité. C'est en fait un véritable coup de génie qu'à réalisé Bull-CP8 en positionnant son invention dans ce domaine, ce qui à l'époque, était loin d'être évident. Entracte : voici la photo d'une carte Bull-CP8 masque M4, recto... et verso.

Cette carte, émise au nom de Supelec Rennes, offrait une application de porte-monnaie privatif sécurisé et a été mise en service en 1986. Sa capacité mémoire de l'époque, couplée au fait qu'elle n'était pas effaçable, permettait de l'utiliser environ 2 ans dans une application de restauration collective (400 transactions). Mais ce qui est intéressant, c'est ce qui est au dos de la carte et qui justifie le véritable intérêt de l'invention de Bull-CP8.

La carte d'aujourd'hui semble peu différer de la carte d'alors. En fait, quelques modifications importantes lui ont été apportées. Nous y reviendrons plus tard mais on peut tout de même citer :

- La ROM est de plus en plus souvent remplacée par de la mémoire flash

- L'EPROM est remplacée par des E²PROM qui ont l'avantage d'être effaçables électriquement (comme la flash d'ailleurs).

- Dans les cartes haute-sécurité, l'horloge est générée en interne.

- De même, la tension de programmation de l'E²PROM est générée en interne.

- De plus en plus de composants cartes proposent de nouveaux modes de communication non forcément exclusifs : sans contact, USB...

Cartes avec contacts

Pour pouvoir utiliser ce micro-ordinateur, il était nécessaire de lui fournir de l'énergie et de lui donner la possibilité de communiquer avec l'extérieur. La normalisation internationale, après bien des péripéties (cf chapitre « Normalisation ») a défini une position à donner aux contacts de la carte et la signification de chacun d'eux. On y trouve, les contacts d'alimentation (Vcc et masse), un contact d'horloge (le micro-processeur est un système synchrone utilisant une horloge qui a l'époque était fournie par l'environnement), un contact pour les entrées/sorties bidirectionnelles à l'alternat, un contact de remise à zéro (ré-initialisation, Reset) et un contact permettant d'appliquer la tension et le courant de programmation pour la mémoire EPROM. Ces 6 contacts étaient complétés par deux autres réservés à un usage futur.

Cartes sans contacts

Assez rapidement, il est apparu souhaitable de disposer de cartes permettant de réaliser des transactions sans qu'il y ait nécessité de les insérer dans un lecteur.

Dans ce mode, le principal problème à résoudre est l'alimentation électrique de la carte. En mode contact, cette alimentation se fait via les contacts. En mode sans contact, il faut trouver autre chose.

Dès les années 1980-1990, il a existé des dispositifs de type « RFID », sans sécurité particulière, utilisant une pile pour transmette des informations. Ces dispositifs étaient par exemple utilisés pour marquer des animaux afin de les identifier (par exemple, pour actionner un dispositif d'entrée-sortie ou pour déverser de la nourriture dans une mangeoire).

C'est également dans ces années que l'on a imaginé utiliser des dispositifs permettant de valider un titre de transport dans un bus ou un métro. Le dispositif pouvait être constitué d'un boitier comportant des piles et un lecteur interne permettant de lire et d'écrire dans une carte à contact que l'on insérait à demeure dans le boitier (un peu comme les cartes SIM) et d'un dispositif de communication RF (radiofréquence) ou infrarouge pour communiquer avec le valideur.

Toutes ces approches sont dites « actives » dans le sens ou la carte, ou ce qui en tient lieu, dispose d'une source d'énergie permettant d'émettre des informations sans dépendre d'un apport d'énergie extérieur et/ou d'alimenter le dispositif électronique.

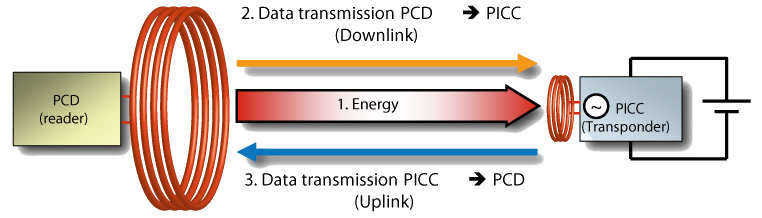

Les composants électroniques consommant de moins en moins, on a pu imaginer des cartes directement alimentées grâce à l'énergie générée par un champ électromagnétique. Les cartes sont alors munies d'une antenne dont le rôle est double :

- D'une part, récupérer l'énergie du champ électromagnétique

- D'autre part, récupérer la modulation de ce champ pour recevoir de l'information ou moduler ce champ pour émettre de l'information.

Ces cartes existent depuis la fin des années 1990 et sont dites « passives ». Ce sont elles qui méritent vraiment l'appellation de Cartes sans contacts. On parle aussi de cartes NFC (pour Near Field Contactless). Cet acronyme signifie que la carte est alimentée et communique en champ proche (quelques centimètres) avec un lecteur. La suite de ce cours ne traitera que de ce type de cartes. Pour rendre les choses plus concrètes, un petit rappel de physique élémentaire.

Principes physique du NFC

Les schémas qui suivent viennent de "RFID handbook" (site inaccessible en 2019).

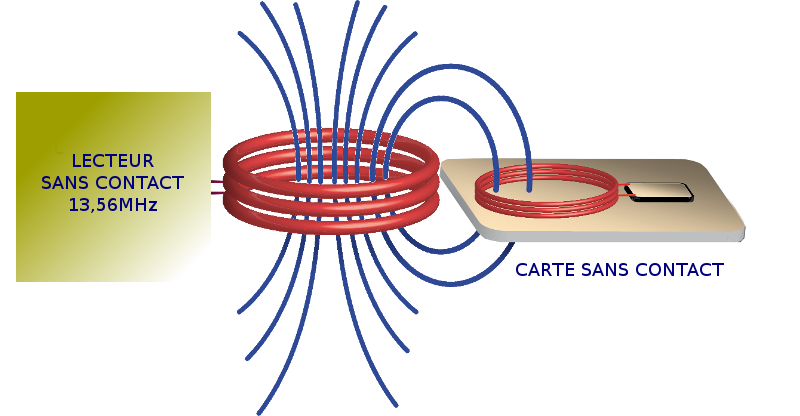

Considérez un bobinage caractérisé par sa forme, le nombre de tour de fil de la bobine et sa taille. Si vous faites passer un certain courant alternatif à une certaine fréquence (13,56MHz pour les cartes dont il est question ici), ce bobinage va produire un champ électromagnétique dans son environnement.

Si vous placez un second bobinage à proximité, sous réserve d'une bonne adaptation et d'une charge adaptée, ce bobinage va récupérer une partie de ce champ électromagnétique qui va générer un certain courant sous une certaine différence de potentiel en fonction de la charge.

Ce courant peut alors être utilisé pour alimenter un montage électronique, dans notre cas, une carte à puce.

Reste à voir comment il est possible de faire passer une information entre ces deux bobinages.

Communications de données

Puisque les deux bobinages sont couplés, si l'on change les caractéristiques de l'un, il y aura une influence sur l'autre. En particulier, si l'on modifie la charge associée à une bobine, on modifie l'impédance de charge vue par l'autre bobine ce qui créé une différence de potentiel qui peut servir à transmettre une information.

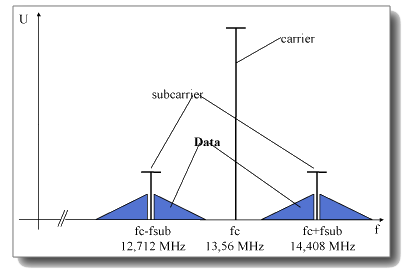

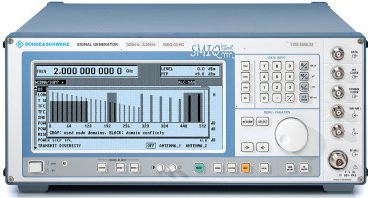

Pour des raisons de performances et de complexité de réalisation, on n'utilise pas directement cette technique. Autour de la fréquence porteuse de 13,56MHz, on va moduler deux sous-porteuses (à 14.0475 MHz et à 12.7125, donc une largeur de bande = 847,5kHz)). Ce sont ces sous-porteuses qui serviront à transporter l'information après un filtrage adéquat visant à supprimer la porteuse. Le débit retenu pour ces fréquences est de 106kbps.

Les modulations utilisées peuvent être l'ASK (une modulation d'amplitude de la sous-porteuse), PSK (une modulation de phase) et FSK (une modulation de fréquence).

Si vous ne savez pas ce qu'est une porteuse ou une modulation, je vous conseille la lecture du livre de Lucien Chrétien, « la TSF sans mathématique », de 1935. Comme vous pouvez le constater, ces techniques ne sont plus très jeunes…

Carte et sécurité, un aperçu

En quoi les cartes à microprocesseur présentent-t-elles une sécurité quelconque ?

Concept de composant monolithique

Par composant monolithique, il faut comprendre que tous les éléments du micro-ordinateur décrits ci-dessus se trouvent implantés sur une seule pastille de silicium (monocomposant). Ce concept très important permet de garantir qu'il est très difficile, de déterminer un chemin de données entre les différents éléments. De cette façon, il est très difficile d'espionner les informations circulant entre le micro-processeur et la mémoire EPROM ni d'intervenir au niveau de cette mémoire pour y mettre des informations non désirées.

Mémoires EPROM et E²PROM

L'utilisation de ce type de mémoire plutôt qu'une simple PROM rend quasi impossible sa relecture par attaque directe (loupe binoculaire ou microscope électronique). En simplifiant, la mémorisation au niveau d'une cellule consiste à piéger des électrons dans la porte d'un transistor à effet de champ. Cette base est isolée du drain et de la source par une barrière isolante d'oxyde de silicium (SIO2). La cellule est programmée en injectant des charges sous haute énergie à travers la couche d'oxyde. Les électrons se trouvent alors piégés dans la porte. Il peut se produire un léger courant de fuite qui fait que la cellule se déchargera spontanément au bout d'un certain temps. Les EPROM sont garanties pour avoir une durée de rétention d'information d'environ 10 ans. En pratique, je dispose de cartes ayant 25 ans et qui conservent toute leur mémoire.

L'inconvénient de l'EPROM est qu'elle n'est pas effaçable de manière simple (on peut l'effacer aux UV, mais en général, d'un bloc). Depuis le début des années 1990, les E²PROM (effaçables électriquement) ont pour cette raison remplacé les EPROM, non sans quelques problèmes au départ. Les premières cartes à E²PROM ont été japonaises. Elles avaient tendance à perdre la mémoire au démarrage du fait d'une mauvaise gestion de la remise à zéro qui entraînait des écritures non contrôlées. Les fabricants ont amélioré le mécanisme de « Reset » et ce problème ne semble plus ce produire aujourd'hui.

Accès à la mémoire

Par construction, il est impossible d'accéder directement aux mémoires de la carte. Toutes les opérations de lecture et d'écriture sont contrôlées par le micro-processeur et son programme associé.

Ces sécurités physiques justifient les moyens logiques mis en oeuvre dans les programmes de la CAM afin d'en faire un moyen sûr pour réaliser les fonctions d'identification, authentification, certification, etc.

Il est délicat de décrire les fonctions offertes par une CAM dans l'absolu. Il est en effet possible de créer autant de programmes d'application de carte que l'imagination le permet. Toutefois, certaines d'entres elles font partie du lot habituel que l'on rencontre sur ce type de carte :

Fonctionnalités externes

Les CAM peuvent exécuter des ordres permettant d'effectuer des opérations de lecture et d'écriture, des calculs cryptographiques, etc. L'exécution de ces ordres peut être soumis à certaines contraintes comme des présentations de codes secrets. Certaines cartes sont conçues pour des usages très généraux (les cartes M4, TB100, DX des années 1980 par exemple ou IAS dans les années 2000). D'autres sont conçues au départ pour un usage plus spécifique comme par exemple, les cartes dites « porte-clés » PC0, PC1, PC2 du CCETT ou les cartes « passeport ».

Identification et authentification du porteur

Dans de nombreuses applications, une carte est affectée à un porteur (utilisateur) donné et identifié (exemple, la carte bancaire, la carte santé). L'accès à certains services nécessite que l'on ait l'assurance que l'utilisateur de la carte en est bien le porteur légitime. De nombreuses cartes offrent un mécanisme d'authentification du porteur. Généralement, cette authentification se fait par l'intermédiaire d'un code secret (ou code porteur ou PIN) que seul le propriétaire de la carte est censé connaître. Ce code est inscrit dans la mémoire E²PROM et le programme interdit sa divulgation à l'extérieur de la carte. C'est la carte elle-même (et non un équipement externe) qui vérifie le code qu'on lui présente et autorise ou non l'exécution des autres ordres que l'on est susceptible de lui présenter. Généralement, il est prévu un mécanisme qui bloque la carte lorsque le nombre de codes faux présentés dépasse une certaine valeur. Certaines cartes offrent la possibilité d'enregistrer une caractéristique biologique de son porteur (ou au moins la signature de cette caractéristique). Il peut s'agir d'une empreinte digitale ou d'un fond d'oeil. Les progrès réalisés dans la reconnaissance de l'écriture manuscrite permettent également de faire une reconnaissance de signature. Si ces moyens d'identification peuvent paraître plus sûr que le code secret, il faut toutefois être conscient que les équipements périphériques permettant la « saisie » du code d'identification sont actuellement relativement coûteux et parfois complexes à mettre en oeuvre.

Authentification de la carte

Dans les télétransactions (transactions à distance via un réseau téléinformatique par exemple), il n'est pas possible de s'assurer visuellement que la carte utilisée n'est pas une carte simulée. On va alors lui faire exécuter un calcul cryptographique dont le résultat dépend d'une information secrète contenue dans sa mémoire. Il est souvent possible de conditionner l'exécution de ce calcul par une authentification préalable du porteur. De cette façon, on a l'assurance, d'une part de dialoguer avec une carte émise par un organisme autorisé et d'autre part, que l'utilisateur de la carte en est bien le propriétaire.

Certification d'information

Comment s'assurer à distance qu'une information censée être lue dans la mémoire d'une carte est effectivement inscrite dans cette mémoire ? Un cas typique est la lecture à distance d'une date de fin de validité ou d'un solde de porte-monnaie. La lecture certifiée d'information est un moyen de s'assurer qu'une information est effectivement inscrite dans la mémoire de la carte. Le mécanisme utilisé est similaire à celui de l'authentification de la carte sachant que le résultat du calcul cryptographique dépendra également de l'information que l'on désire certifier.

Cryptographie

Certaines applications nécessitent de chiffrer les informations à transmettre. Jusqu'à l'apparition des méthodes de chiffrement à clé publique, un des problèmes consistait à faire parvenir de façon sûre, la clé de déchiffrement au destinataire. Grâce à ses fonctions de calcul et les informations secrètes pouvant être contenues dans la mémoire de transaction, la carte peut être utilisée comme générateur de clé pour une machine à chiffrer et même se substituer à cette dernière.

La plupart de ces fonctions sont rendues possibles grâce aux fonctions de calcul offertes par la carte. Ces fonctions peuvent être secrètes (cf fonction TELEPASS de Bull-CP8 dans la carte M4) ou publiques (le DES, l'AES par exemple), à clé secrète ou à clé publique (RSA, courbes elliptiques).

Tout cela ne s'est pas fait sans mal. Dans les années 1980, la cryptographie était contrôlée et nécessitait des autorisations de la part du service du chiffre puis du SCSSI (Service Central de la Sécurité des Systèmes d'Information, créé par Laurent Fabius en 1986). Généraliser l'utilisation d'une carte à puce bancaire revenait donc à généraliser le port d'arme pour tous les citoyens puisque la cryptographie était considéré comme une arme de guerre pour les opérations de chiffrement (décret loi de 1939). Finalement, les cartes furent décontrôlées moyennant le fait qu'à l'époque, elles ne pouvaient pas mettre en oeuvre des algorithmes trop sophistiqués (ce qui de toute façon était rendu difficile par le peu de capacité mémoire et puissance de calcul des composants de l'époque) et moyennant le fait qu'elles ne faisaient pas de chiffrement (TELEPASS était une fonction non réversible à clé secrète). Depuis la fin des années 1990, la tendance est plutôt inverse et les cartes sont devenues de véritables ressources cryptographiques.

ACTEURS DE LA CARTE

Si l'on exclue les émetteurs de cartes et les sociétés de services et d'ingénierie, les principaux intervenants dans la fourniture des moyens CAM sont :

- les fabricants de composants électroniques,

- les concepteurs des « masques programme »,

- les encarteurs/imprimeurs,

- les personnalisateurs.

Comme on le verra, certaines de ces fonctions sont souvent regroupées au sein d'une même société.

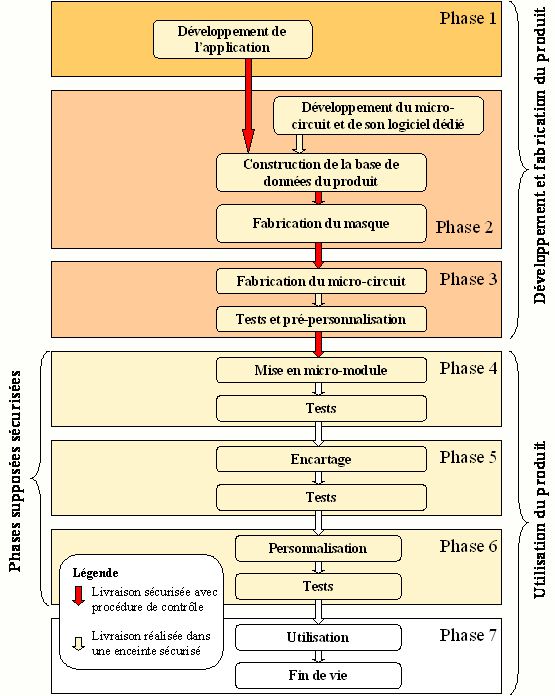

La figure ci-dessous décrit les différentes phases de vie d'une carte à puce et permet de mieux comprendre l'intervention des différents acteurs décrits ci-après.

Les fabricants de composants

Les fabricants de composants pour CAM dîtes « haute sécurité » sont peu nombreux. On trouve essentiellement quelques Européens, quelques Japonais et un Coréen. MOTOROLA a été la première entreprise capable de fournir industriellement des composants pour CAM avec une offre basée sur le 6805. Ce composant utilisé entre autres pour la carte M4 disposait de 1,6 ko de mémoire programme, 1 ko de mémoire de transaction et 36 octets de mémoire vive. MOTOROLA n'est néanmoins pas resté sur ce marché, suite peut-être aux problèmes connus par les premières cartes PC2 pour la télévision à péage.

Le consortium THOMSON-SGS, devenu ST Microelectronics est un des autres acteurs majeur dans le domaine de la fourniture de composants. La première offre était basée sur le 8048. Il disposait d'une mémoire programme de 2 ko, d'une mémoire de transaction de 1 ko et de 48 octets de mémoire vive. Depuis, la gamme s'est étoffée et après un passage à vide au milieu des années 2000, le groupe refait partie des fournisseurs importants de ce type de composants.

PHILIPS-TRT a été la première société à produire en 1992 un composant permettant l'exécution d'algorithmes à clé publique (RSA, GQ...) dans un temps raisonnable (pour plus de précisions voir le chapitre « Premières crypto-cartes »).

Ce composant a été utilisé dans la carte DX avec l'algorithme RSA et dans la carte Mimosa de Gemplus avec l'algorithme GQ. Petit à petit, on a oublié TRT, puis cette activité de PHILIPS a été vendue à un fond de pension. En 2012, la société s'appelait NXP.

SIEMENS a également été un fournisseur important de composants pour cartes à puce. Cette partie de l'activité a pris son indépendance en 1999 sous le nom d'INFINEON.

SAMSUNG, considéré comme le deuxième fabricant de composants dans le monde en 2012, est devenu un des fournisseurs important de composants sécurisés.

ATMEL (partie européenne) fut également une société réputée dans ce domaine. ATMEL corporate a revendu cette activité en 2010 à la société française INSIDE CONTACTLESS, devenue pour la circonstance, INSIDE SECURE. A noter qu'INSIDE SECURE est ce qu'on appelle un fabless : la société ne dispose pas de sa propre fonderie (là où les composants sont fabriqués). Il sous-traite donc cette activité.

En mai 2016, Inside secure a définitivement abandonné l'activité « composants » en la revendant à la société Suisse WISeKey. WiseKey n'étant pas particulièrement reconnu dans ce domaine, cet événement marque probablement la fin de la filière issue d'ATMEL.

Les Japonais ont eu également plusieurs sociétés fabriquant des composants pour cartes à puce. Citons en particulier HITACHI, TOSHIBA, NEC, SHARP, OKI.

Enfin, à partir des années 2000, l'industrie chinoise était de plus en plus présente sur ce marché mais en 2017, les composants fabriqués n'étaient pas considérés comme de « haute sécurité ».

Puisque l'on parle de composants, il est temps de donner une petite idée des performances de ceux que l'on a pu trouver sur le marché jusqu'aux modèles actuels.

|

Fab. & Ref. |

Année |

ROM |

E²PROM |

Flash |

RAM |

Processeur |

|

Motorola |

~1983 |

1,6ko |

1ko |

NA |

36o |

6805, 8bits, 4MHz |

|

TRT-Philips (NXP) |

~1995 |

16ko |

4ko |

NA |

256o |

80C51, 8 bits, 10MHz |

|

Inside Secure/Atmel |

~2010 |

|

|

NA |

|

RISC SecureAVR 8/16 bits, |

|

Infineon |

~2010 |

288ko |

144ko |

NA |

8 ko |

Dual 16 bits, 33MHz |

|

ST Microelectronics |

~2011 |

256o d'OTP + ROM sys. |

NA |

1 280 ko |

30 ko |

ARM SecureCore, RISC 32 bits, 30MHz |

|

ST Microelectronics |

~2016 |

NA |

2 048 ko |

50 ko |

ARM SecureCore, RISC 32 bits, 60MHz, double coeur |

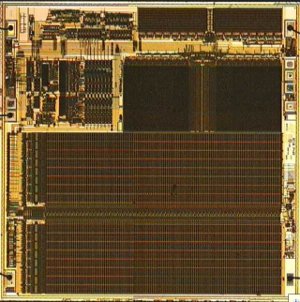

Et voici deux photographies de deux composants ayant environ 10 ans d'écart. On note une plus grande accessibilité aux bus sur le premier composant que sur le second ou tout semble noyé (glue logique). Sachant que le second composant avait probablement un bouclier actif qui a été retiré pour la photo. Voila pourquoi, les technologies évoluant, il est important de ne pas laisser trop longtemps des cartes sur le terrain. Des composants qui étaient résistants à des attaques de haut niveau il y a dix ans ne le sont plus forcément aujourd'hui.

Les concepteurs de masques

Il n'est question dans ce chapitre que des sociétés qui proposent des cartes dites de « haute sécurité ».

Le concepteur de masque le plus connu dans le domaine des CAM « haute

sécurité » a longtemps été le créateur du concept lui-même à savoir Bull

CP8 créée en 1985 avec son MAM (Micro calculateur Auto-programmable Monolithique).

Cette société a en particulier réalisé la carte M4 utilisée en France pour les

applications bancaires et téléphonique (carte PASTEL). En 1993, L'offre Bull-CP8

portait sur une dizaine de masques dont certains ont été initialement conçus

par des organismes de recherche (CCETT par exemple).

En 1990, Bull-CP8 et François-Charles

Oberthur ont conclut un accord de partenariat qui a eu pour conséquence

de transférer l'activité d'encartage de Bull-CP8 depuis ses locaux de Trappes

dans de nouvelles unités de production en Bretagne (CP8-Oberthur et CP8 Micro-électronique).

L'activité de production de masque sera finalement reprise par la société Axalto

elle-même issue de la société Schlumberger (voir ci-après). Bull n'a donc plus d'activité dans ce domaine.

Pour la petite histoire, Bull a été reprise par la société ATOS en 2014. ATOS était issue de la fusion d'Axime,

Sligos et GSI. On se rappellera que Sligos a été une société importante dans l'encartage via sa filiale Solaic,

revendue en 1996 à Schlumberger (qui a donné naissance à Axalto devenue Gemalto suite à la fusion avec Gemplus, voir plus loin).

ATOS et Bull ont donc toutes deux eu à faire avec la carte à puce dans leur histoire et toutes les deux, ont finit par

abandonner cette activité. Qu'en conclure ? Rien. C'était juste pour l'anecdote.

Sauf qu'en décembre 2017, l'histoire aurait pu bégayer. Suite à une baisse de ses activités, Gemalto s'est trouvée dans la position d'être repris par le marché. C'est ATOS qui a tiré le premier en lançant une OPA sur la société. Mais c'est finalement Thalès qui a remporté le morceau. Avec le rachat de Morpho quelques mois auparavant, l'année 2017 aura été fertile en bouleversements dans le marché de la carte.

Reste à savoir si Thalès saura valoriser cette acquisition. Rien n'est moins sur... Rendez-vous dans quelques années.

Philips-TRT que l'on a déjà cité parmi les fabricants de composants est également un concepteur de masques. Les cartes D1 et D2 produites à la fin des années 1980 étaient particulièrement bien adaptées aux applications de sécurité (contrôle d'accès et d'habilitation à des systèmes d'informations, signature électronique...). En 1989, un accord a été signé avec Bull-CP8 afin de mettre en commun les ressources nécessaires en matière de recherche et développement de nouveaux masques. Le premier résultat de ce travail commun a été la carte TB100 (TB pour TRT/BULL) reprenant une partie des fonctionnalités de la carte MP de Bull-CP8. Cette entité a été vendue à l'anglais Delarue.

Schlumberger a longtemps revendiqué le titre de premier producteur de CAM au monde. En fait, tout dépend de la définition que l'on donne au terme « carte à mémoire » (cf chapitre précédent). Si l'on ne prend en compte que les cartes à micro-processeur, Schlumberger n'était dans les années 1980 qu'un tout petit producteur (ce qui n'exclut pas d'avoir de l'ambition). Jusqu'en 1990, le plus gros de la production de cette société était encore la carte F256 (carte en logique câblée) avec comme plus gros client France-Télécom (Télécarte). A partir de 1997, Schlumberger pouvait revendiquer une place de leader aux cotés de la société Gemplus. Finalement, l'activité carte de Schlumberger donnera naissance à la société Axalto qui reprendra les activités de conception de masque et de lecteurs de Bull-CP8.

Gemplus, créé en 1988 a eu un démarrage fulgurant grâce à un produit particulièrement souple : le COS (Chip Operating System, voir le chapitre consacré aux cartes COS). L'offre de cette société était basée sur un masque programme offrant des fonctionnalités de base, quelque soit le composant utilisé et laisse à l'utilisateur final le soin de rajouter les fonctions spécifiques qui lui étaient nécessaires. On avait donc une offre réduite en terme de masque programme mais une adaptabilité très grande. Au delà de la carte COS, Gemplus a également conçu beaucoup d'autres masques programmes dont certains, très spécifiques comme la carte MIMOSA pour le CCETT (France Télécom) implémentant l'algorithme GQ pour Guillou-Quisquater.

Finalement, en 2005, Axalto et Gemplus annonceront la fusion de leurs activités pour créer le leader mondial dans la réalisation de cartes. La société issue de cette fusion sera baptisée Gemalto.

Après avoir repris les activités de production de Bull-CP8, Oberthur SC a racheté les activités cartes de Delarue et a commencé la conception de masques. En 2012, Oberthur était considéré comme un des trois premiers mondiaux dans le domaine de la carte. Cette activité a été revendue par son fondateur à un fond de pension américain en 2011, le fondateur ne conservant que l'activité fiduciaire (fabrication de billets de banque entre-autres).

Sagem a également longtemps été un concepteur de cartes et ce, dès les années

1980. En 2005, Sagem rachètera le fabricant allemand Orga pour devenir Sagem-Orga

puis ensuite, Morpho.

Finalement, Oberthur a racheté Morpho pour donner naissance en septembre 2017 à un nouveau groupe

nommé Idemia (nom que je trouve particulièrement sans saveur !).

En 2012, les principaux fabricants de cartes étaient donc :

- Gemalto, considéré comme le n° 1 mondial

- Oberthur considéré comme le n° 2 ou 3 mondial, cette place se disputant avec l'allemand Giesecke & Devrient.

- Morpho, considéré comme le quatrième fabricant mondial.

En 2017, on pouvait envisager le palmarès suivant :

- Gemalto, considéré comme le n° 1 mondial, racheté par Thalès en décembre 2017

- Idemia (Oberthur-Morpho), créé suite au rachat de Morpho par Oberthur.

- Giesecke & Devrient.

Il semble que ce palmarès soit toujours valable en 2021.

A coté de ces poids lourds, il existe une multitude de petites ou moyennes sociétés oeuvrant dans le domaine des cartes de haute sécurité. On pourrait citer EDSI, société basée à Rennes (France) et fondée par Michel Hazard, un des créateurs des premiers masques de Bull-CP8. Michel Hazard ayant souhaité prendre sa retraite, il a vendu sa société à Nagra en 2008. On pourrait également citer Innovatron créée par Roland Moreno qui a produit (elle-même ou une de ses filiales) des masques de cartes.

Les encarteurs

Les encarteurs partent d'un composant déjà masqué (programmé) et l'insèrent dans une carte plastique au format ISO. En pratique, beaucoup des concepteurs de masques cités précédemment (Gemalto, Oberthur, G&D, Morpho) réalisent cette opération. Dans les années 1980, de nombreux encarteurs venaient du monde de l'impression (par exemple, SG2, filiale de la banque Société Générale, mais aussi Oberthur, Delarue, Ruwa Plast (ex Ruwa Bell), etc.) sachant qu'une activité importante dans le monde des cartes consistait déjà à traiter le support (découpage, impression, embossage). Toutefois, au moins au début de la carte, un des principaux problème consistait à se doter de machines capables d'insérer le composant dans le support plastique, en plus, parfois de créer ce que l'on appelle le micro-module, c'est à dire, le composant monté sur ses contacts.

Tous les grands encarteurs que j'ai connus ont créé leurs machines, jusqu'à ce que le marché soit suffisamment développé pour qu'une offre industrielle soit enfin disponible. C'est peut-être ce qui a fait la différence entre ceux étaient en mesure de spécifier et de faire fabriquer (ou fabriquer eux-mêmes) ce genre de machine et les autres qui n'étaient concentrés que sur le processus industriel (typiquement, les imprimeurs).

Les personnalisateurs

La personnalisation électrique d'une CAM (par opposition à la personnalisation graphique) consiste à inscrire les informations indispensables à l'application pour laquelle elle est émise. Ces informations peuvent être l'identité du client, le code porteur, les clés secrètes, etc. En pratique, les encarteurs / imprimeurs cités précédemment et parfois, des SSII (Sligos avec Solaic, Segin...) ont du apprendre à réaliser cette opération de façon industrielle. En 2012, cette activité avait déjà subie une forte concentration et se trouvait regroupée chez les concepteurs de masques.

Toutefois, le métier de l'impression continue à s'intéresser au monde de la carte puisqu'en France, la société « Imprimerie Nationale » est également devenue un personnalisateur.

Au final, depuis les années 2000, c'est la fonction de « personnalisateur » qui désigne les grands industriels de la carte ce qui est assez logique car le personnalisateur est le dernier maillon de la chaîne avant d'arriver chez l'émetteur de la carte (issuer en anglais), c'est à dire, celui qui achète et diffuse le produit à l'utilisateur final..

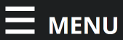

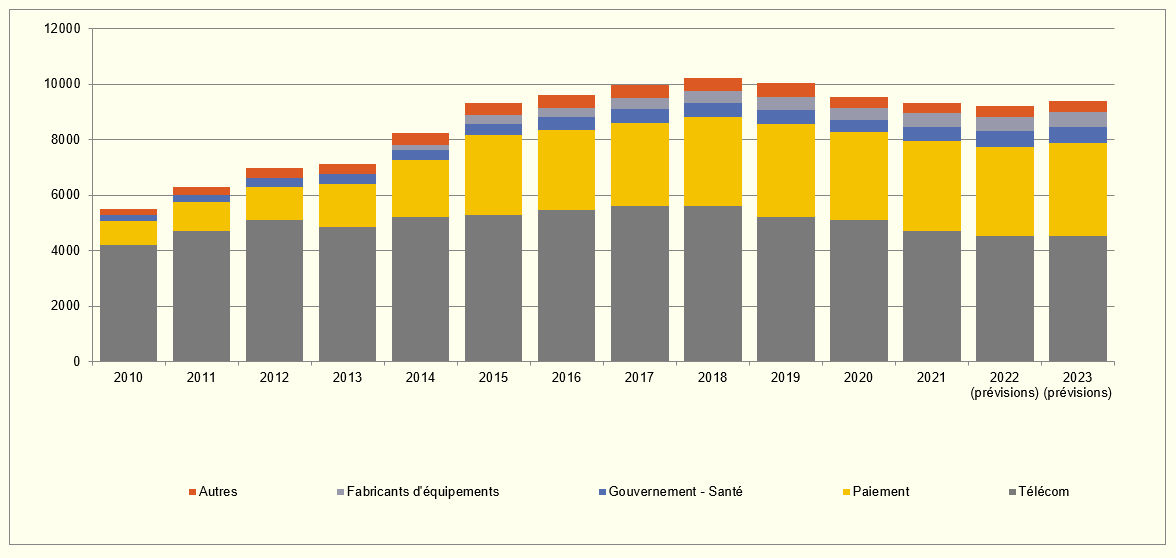

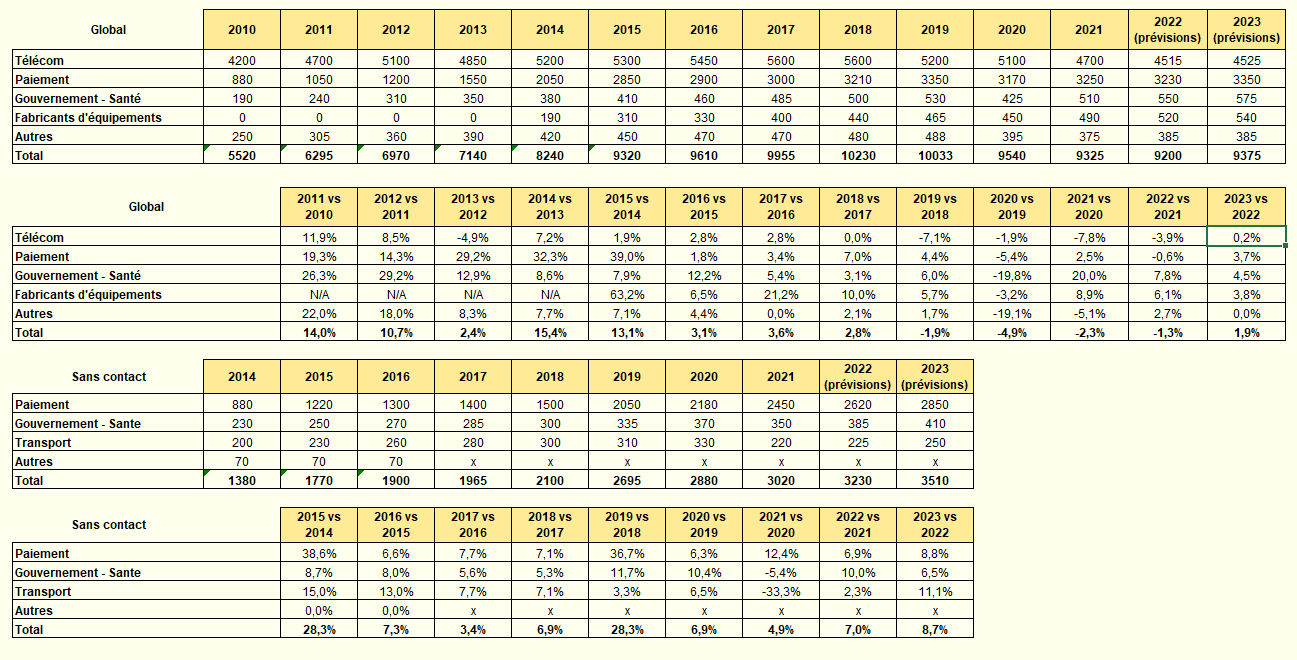

Le marché de la carte

Les chiffres parlent d'eux-mêmes (source Eurosmart). En 1995, le marché des cartes à microprocesseur représentait environ 60 millions d'unités (environ 10 milliard en 2018) et le marché des cartes en logique câblées représentait environ 300 millions d'unités. le marché français représentait alors la moitié du marché mondial en terme d'émission. C'est en 2000 que le nombre de cartes émis dans le monde est devenu supérieur à celui émis en France.

Mais en 2019, l'émission de cartes à commencé à baisser et en 2025 (dernière mise à jours des statistiques ci-après), Eurosmart ne publiait plus les chiffres définitifs. Peut-être la fin d'une époque, ce qui peut sembler paradoxal alors qu'on parle de plus en plus de sécurité de l'information.

Il y aurait beaucoup à dire à ce sujet mais ce n'est pas le thème de ce cours.

Nombres en millions d'unités (cliquez pour agrandir)

Production en million d'unités

Légende

Télécom : Cartes SIM cards (éléments sécurisés avec une application SIM).

Paiement et banque : cartes émises par les banques et les enseignes pour des services de paiement (débit, crédit, prépaiement...). Cartes émises par d'autres fournisseurs de service ou enseignes pour la fidélité. Cartes à usage social avec application de paiement.

Gouvernment et santé : cartes émises par des organisations gouvernementales pour l'identification des citoyens (documents de voyage, d'identité, de santé) et les services en ligne opérés par des compagnies d'assurances privées dans le domaine de la santé.

Fabricants d'équipements : Téléphones mobiles, tablettes, outils de navigation et autres objets connectés comportant un élément sécurisé sans application SIM.

Autres : Cartes émises par des opérateurs pour le transport, le stationnement (i.e. transport). Cartes émises par les opérateurs de télévision à péage (i.e. pay-tv). Cartes d'accès physique ou logique.

LA SÉCURITÉ DE LA CARTE

La sécurité de la carte telle qu'elle a été conçue par Bull repose sur son caractère « non-reproductible », ou « non-clonable ». En quelques mots, ayant une carte entre les mains dans un état « émis » (carte dans l'état où elle doit être fournie à son utilisateur légitime), vous (ni personne d'autre) ne pouvez la dupliquer pour faire une carte ayant les mêmes caractéristiques. Eventuellement, l'émetteur de la carte sera en mesure de créer d'autres cartes ayant les mêmes caractéristiques à condition qu'il ait conservé les données qui ont été inscrites dans la carte avant qu'elle passe dans l'état « émis » (c'est vrai pour les cartes bancaires par exemple). Dans certaines applications (signature électronique par exemple), même l'émetteur n'est pas en mesure de créer une nouvelle carte ayant les mêmes caractéristiques que celle qu'il vous a fournie précédemment.

Cet objectif de sécurité ne peut être atteint que si certaines conditions sont réunies :

- le dispositif matériel (micro-contrôleur) sur lequel repose la carte est « inviolable » pour reprendre le terme de Bull CP8, ce qui évidemment est une caractéristique non atteignable dans le monde réel. On se contentera plus modestement de demander à ce que le viol d'un composant soit d'une complexité telle qu'en pratique, cela ne vaudra pas la peine d'essayer, sauf s'il y a de très forts enjeux à la clé.

- le logiciel de la carte a été conçu pour atteindre cet objectif et fonctionne tel qu'il a été spécifié

- la sécurité finale ne dépend que de l'émetteur de la carte et dans certains cas, également de son porteur (cas où le porteur ne peut pas faire entièrement confiance à l'émetteur).

Avant d'aborder chacune de ces conditions et de voir comment on les vérifie, on dispose à la date de rédaction de ce document de suffisamment de recul pour déterminer si les cartes répondent à cet objectif.

Quelques attaques sur les cartes

Beaucoup d'attaques sur les cartes citées par la presse généraliste n'en sont pas. Cette affirmation peut sembler bizarre à certains et mérite une petite illustration en guise d'explication

Attaque sur les Télécartes

La première attaque sur les cartes dont je me souviens a fait la une des magazines dans les années 1980. A cette époque, des étudiants grenoblois s'étaient fait pincer par la police parce qu'ils vendaient de fausses Télécartes qui étaient fonctionnellement acceptées par les publiphone.

La presse française de l'époque avait alors titré sur le fait que les cartes qu'on voulait nous faire croire comme étant sûres ne l'étaient pas (« vous pensez, des étudiants... ») en faisant l'amalgame avec les cartes bancaires que l'on commençait à émettre à titre expérimental en Bretagne.

Pour ceux qui ne savent pas comment fonctionnaient les Télécartes de l'époque, il y a un petit chapitre à ce sujet dans ce cours. Mais en résumé, les Télécartes ne répondaient absolument pas au critère de non-reproductibilité. Il s'agissait d'une simple mémoire de 256 bits en lecture libre, comportant dans une partie non réinscriptible, une information identifiant France-Télécom et pour le reste, un nombre de bits pouvant être écrits, chaque bit correspondant à une taxe téléphonique.

Les étudiants se sont contentés d'émuler ce fonctionnement dans un microcontrôleur avec quelques centaines de lignes d'assembleur (pour l'essentiel, gestion du dialogue carte qui est particulièrement simple dans le cas présent et émulation du fonctionnement de la mémoire qui est encore plus trivial).

Parler d'attaque sur les cartes à ce propos était donc un non-sens puisque la carte ne prétendait à aucune sécurité (à par la protection en écriture de certains bits). Il s'agissait en fait d'une attaque sur le système.

L'affaire Humpich

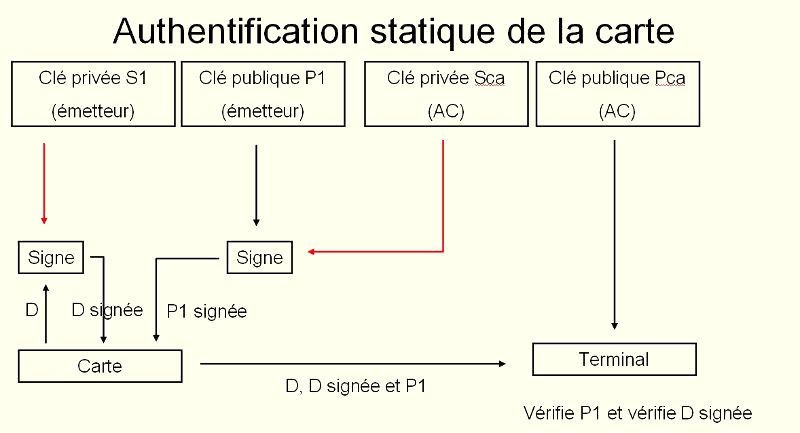

L'affaire Humpich commence par le « cassage » d'une clé RSA de 320 bits par Humpich. Cette clé était utilisée pour mettre en oeuvre une authentification statique des cartes bancaires. Une fois la clé cassée, il était alors possible de réaliser de vraies-fausses cartes pouvant être utilisées en yes-card (une carte qui répond toujours ok à une présentation d'un code porteur ou PIN). Cette authentification statique était mise en oeuvre de la façon suivante

- lecture par un terminal souhaitant authentifier la carte d'une donnée en lecture libre appelée « valeur d'authentification » ou VA. Cette VA était la signature d'un certain nombre d'informations en lecture libre et stockées dans la carte (en particulier, PAN, n° de série du composant, dates de validité...).

- Calcul de vérification de signature à partir de la VA et de la clé publique correspondant à la clé privée ayant permis de constituer la VA.

- Si le résultat du calcul permettait de retrouver les informations signées et mémorisées dans la carte, alors, on pouvait en conclure que la VA avait bien été générée par une autorité connaissant la clé privée, donc, une banque.

Cette mise en oeuvre ne fait nullement intervenir un mécanisme de sécurité de la carte qui se comporte ici comme un simple support de mémorisation. On aurait pu faire de même avec une carte à piste magnétique si celle-ci avait eu la possibilité de mémoriser une quantité de données suffisante.

Une partie de la sécurité du système reposait donc sur le fait que la clé RSA devait être l'état de l'art. Mais déjà, en 1988, Louis Guillou écrivait un article dans « Pour la Science » dans lequel il expliquait que les clés de 320 bits n'assuraient plus la sécurité de la valeur d'authentification des cartes.

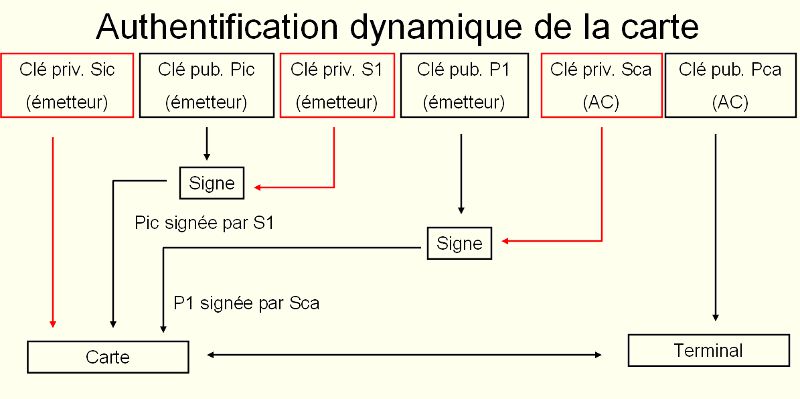

En pratique, l'authentification statique des cartes, qui pouvaient convenir pour assurer la sécurité du système à son lancement, n'était plus adaptée dans les années 1990. Il fallait passer à l'authentification dynamique (vérification de la possession par la carte de la clé privée via un challenge) ce qui fut fait quelques années plus tard.

Ce cas est emblématique des confusions qui ont été faites à l'époque sur la sécurité des cartes. La sécurité des cartes bancaires, s'inscrivant dans un système particulier (le système CB) avait bien été compromise, mais sans qu'il y ait une attaque sur les cartes.

Cette affaire a été très médiatisée à l'époque. Il est intéressant de savoir comment elle s'est conclue, ne serait-ce que pour éviter de se retrouver dans une mauvaise situation lorsque l'on est amené à expérimenter dans le domaine des cartes.

Humpich a été condamné pour avoir accédé sans autorisation à un STAD (système de traitement automatisé de données). Cette condamnation a été confirmée par la cour d'appel de Paris en 2000. On trouve un résumé de ce point sur le site Légalis [archive]

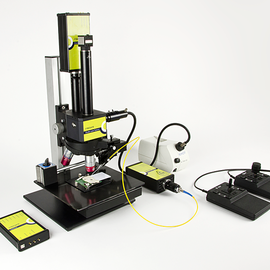

Les publications sous l'égide de Ross Anderson

Ross Anderson de l'université de Cambridge au Royaume Uni (décédé en 2024) s'est fait une spécialité de publier des attaques sur les cartes à puce. Si certaines sont de vraies attaques, dans le sens où elles visent à mettre en défaut des mécanismes de sécurité des cartes en général (par exemple, via des attaques semi-invasives utilisant des lasers ou des impulsions électromagnétiques), beaucoup d'autres, sont liées aux systèmes qui les mettent en oeuvre comme par exemple, celle publiée en 2010. Cette attaque utilise la technique de « l'homme dans le milieu » afin de faire croire à un terminal qu'un PIN a été présenté lors d'une transaction EMV. Cette attaque est rendue possible parce que l'information provenant de la carte et indiquant qu'un PIN correct a été présenté n'était généralement pas utilisé à la date de parution de l'attaque.

A noter au passage que la carte bancaire M4B0 du milieu des années 1980 disposait déjà d'un mécanisme qui permettait de « signer » le fait qu'une transaction s'était déroulée selon un processus normal (avec présentation du PIN en particulier). Inconvénient, seule la banque était en mesure de vérifier le cryptogramme car à l'époque, l'algorithme était un hash-MAC. Mais le point avait été bien vu dès cette époque.

Une attaque sur les cartes bancaires NFC

En avril 2012, un consultant français (Renaud Lifchitz) publie une présentation (Hacking the NFC credit cards for fun and debit) montrant qu'il est possible de récupérer les informations circulant en clair entre une carte bancaire sans contact et un terminal. la presse parle « d'une incroyable faille dans les cartes bancaires » en précisant qu'il s'agit d'une découverte.

Là encore, la sécurité de la carte elle même n'est pas en cause puisqu'à aucun moment, il n'a été prévu une quelconque protection en confidentialité des informations transmises. Il s'agit donc bien d'une caractéristique du système qui par conception transmet les données en clair. Quel impact ? Deux points de vue sont à considérér : celui de la protection de la vie privée et celui de la fraude :

Pour la CNIL (vie privée), certaines informations sont considérées comme personnelles (nom, log des transactions).

Ce problème a été en partie réglé puisqu'en 2012, un rapport de

l'OSCP (Observatoire de la Sécurité des Cartes de Paiement devenu Observatoire des moyens de paiement en 2016) précisait que "le nom du porteur n'est en

effet plus accessible lors des échanges en mode sans contact pour la très grande majorité des cartes émises

en France. En ce qui concerne l'accès à l'historique des transactions sur les supports sans contact, le

système « CB » a pris la décision d'interdire, pour tous les produits désormais présentés à l'agrément,

la lecture de ces données par l'interface sans contact".

Pour les banques (fraude), le président du groupement des Cartes Bancaires signalait en avril 2015 l'absence de fraude constatée. Il est vrai que si l'on peut imaginer des scénarios de fraudes, ceux-ci sont quelques peu alambiqués et n'intéressent probablement pas ceux dont l'objectif est « de faire du chiffre ». Par contre, ils continuent visiblement d'intéresser ceux « qui veulent faire du buzz ».

Mais ce qui nous intéresse dans ce paragraphe, c'est la façon dont le sujet a été traité par les médias. De ce point de vue, on peut être partagé :

Par rapport aux années 2000, on peut se féliciter que la presse a cette fois su faire la distinction entre la sécurité des cartes en général et la sécurité des systèmes qui les mettent en oeuvre.

Par contre, le fait que cette information ait suscité tant de bruits est plus problématique et montre une fois de plus combien la recherche d'un certain « sensationnalisme » se fait au détriment de l'information. Il faut rappeler qu'en 2007 (5 ans avant « la découverte »), l'OSCP publiait dans son rapport annuel « Compte tenu des spécifications actuelles des réseaux internationaux Visa et Mastercard, les nom et prénom du porteur peuvent être transmis en mode sans contact de façon non protégée, ce qui pose un problème de protection de ces données ».

En bref, la présentation de Lifchitz était « un coup de com » dans le mauvais sens du terme. Du point de vue technique elle ne faisait qu'illustrer quelque chose de déjà bien connu.

En guise de première conclusion

Sur la trentaine d'années durant lesquelles des cartes « haute-sécurité » ont été émises, le nombre de cas de cassages avérés de cartes est finalement très faible durant leur période normale d'emploi.

Les plus connues et les plus spectaculaires concernent la télévision à péage : dans ce domaine, le principe même du système fait qu'il est possible d'imaginer un modèle économique rentable qui justifie des moyens lourds pour violer quelques cartes. Cela a donc été fait et la bagarre est permanente entre ceux qui attaquent et ceux qui conçoivent les nouvelles cartes.

Les attaques proviennent parfois d'une erreur de construction (un bug logiciel) découvert plus ou moins par hasard par quelqu'un. Ces cas ont été assez rares en pratique puisque jusqu'à une époque récente, le développement des cartes était assez bien maitrisé par les masqueurs.

| Ne demandez pas des fonctionnalités trop complexes à une carte. La complexité est l'ennemie de la sécurité |

La complexité des nouvelles cartes augmentant considérablement, il est possible (probable) que le nombre de bugs va lui aussi augmenter, rendant intéressante la recherche des erreurs de construction qui peut souvent être faite à moindre coût avec simple PC et un lecteur. Si ces cas venaient effectivement à se généraliser, ils mettraient en péril tout un pan de l'industrie.

Il existe aussi des erreurs de construction sur le matériel qui favorisent plus ou moins les possibilités d'attaques. Je connais au moins un cas où une carte a été émise avec un composant comportant un problème de fabrication connu. Il a fallu attendre très peu de temps pour qu'il soit exploité. La leçon que l'on doit en tirer est que si on connait une faiblesse, il ne faut pas trop compter sur le fait de ne pas la divulguer pour empêcher son exploitation. Si les enjeux en valent la peine, elle sera exploitée.

Certains cas d'attaques réussies concernent des cartes qui ont été émises il y a fort longtemps. Les techniques de microélectroniques évoluent, les équipements de conception et de test également, donc les équipements d'attaque aussi... puisque ce sont souvent les mêmes. La sécurité d'une carte ne fait donc que se dégrader dans le temps. Ce qui était très difficile à une époque devient simplement difficile un peu plus tard jusqu'à devenir parfois trivial. Il est certain que les cartes émises dans les années 1980 ne résisteraient pas à des attaques de niveau élementaires en 2015 (voir le chapitre sur l'évaluation des cartes), alors que lorsqu'elles sont émises, toutes les cartes « haute sécurité » visent un niveau de résistance élevé aux attaques. Dit autrement, il ne faut pas compter que les cartes émises à un instant t puissent conserver leur dénomination « haute sécurité » au delà de quelques années.

| Le niveau de résistance d'une carte donnée se dégrade avec le temps |

La conséquence est que les émetteurs de cartes doivents déterminer une période de validité des cartes en fonction des risques assumés et surveiller le niveau de résistance réelle des cartes sur le terrain.

Une autre règle à connaitre est que les cartes ne sont pas « intrinsèquement » sûres. Certains émetteurs ayant des exigences de sécurité élevées demandent à ce que cette sécurité soit vérifiée à travers des évaluations. Les chapitres qui suivent donnent un aperçu de leur contenu.

Mais là comme ailleurs, il n'y a pas de mystère :si l'émetteur ne formule pas d'exigences particulières en matière de vérification de la sécurité, la résistance des cartes qu'il émettra sera très aléatoire. D'où le nombre régulier de publications portant sur des attaques de cartes réussies et parfois triviales : beaucoup de cartes émises ne peuvent pas être considérées comme visant une « haute-sécurité ».

| Une carte n'est pas intrinsèquement sûre. Seule, une évaluation de la sécurité permet d'avoir une idée de sa résistance aux attaques |

Enfin et pas que dans ce domaine, il faut conserver un oeil et un esprit critique vis-à-vis des publications, y compris, des publications universitaires : la recherche est devenue depuis longtemps un business comme un autre. Le travail de beaucoup de chercheurs, parfois renommés, est de chercher... des financements pour leurs laboratoires. Et une façon d'en faciliter l'obtention est de publier.

C'est ainsi que dans certains milieux de la sécurité, on parle de « livraison annuelle » de tel ou tel chercheur car là comme ailleurs, il faut bien vivre... Parfois, ces publications révèlent des pépites. Mais souvent, on a à faire à du réchauffé (combien d'articles sont republiés après quelques modifications pour faire du « chiffre » : le nombre de publications est un critère de notation pour les chercheurs). Si on y ajoute les « annonces » de certains en mal de notoriété destinées à créer du buz médiatique, on comprendra que le travail d'explication est nécessaire, même s'il est souvent perdu dans le bruit.

L'évaluation de la sécurité des cartes

La question de l'évaluation de la sécurité des cartes ne s'est pas posée immédiatement ; Le marché s'est d'abord contenté de l'affirmation de Bull concernant « l'inviolabilité » de ses cartes.

Lorsqu’en 1990, certains établissements financiers (Caisse d'Épargne, Caisse des Dépôts et La Poste) ont souhaité lancer leur premier porte-monnaie électronique, l’affirmation des fournisseurs sur la sécurité des cartes est apparue insuffisante face aux risques de création de fausse monnaie.

Ce questionnement était justifié. Jusqu'en 1994, les industriels concernés étaient peu nombreux, et honorablement connus. A partir de 1995 le marché s'est développé à grande vitesse. De multiples projets apparaissaient, la technologie se banalisait, de nouveaux acteurs plus ou moins connus voyaient le jour, le marché devenait mondial.

A partir de ce moment, il n’était plus possible de se baser sur les seules déclarations des fournisseurs pour la sécurité.

C’est en France, que se sont développées les premières évaluations de cartes et de composants en se basant sur des normes d’évaluation internationales reconnues (les critères européens ITSEC dans un premier temps, puis les Critères Communs). La toute première a été réalisée entre 1992 et 1993 par le Centre d’Électronique de l’Armement (CELAR, en 2016, DGA/MI, Ministère de la défense) et le laboratoire d’évaluation sécurité de la société Alliance Qualité Logiciel (AQL). Le CELAR se chargeait d’évaluer le composant électronique, AQL réalisait l’évaluation ITSEC du logiciel de la carte. Les résultats ont été présentés alors au salon Cartes 93.

Mais le véritable booster est arrivé lorsque la Banque de France a demandé au GIE-CB des preuves concernant la sécurité des cartes bancaires.

Le GIE-CB s'est alors tourné vers le SCSSI (devenu depuis l'ANSSI) pour faire évaluer la sécurité des cartes et a inscrit dans son règlement que l'agrément des cartes bancaires (c'est à dire, en pratique, le sésame permettant aux fournisseurs de cartes de vendre aux banques) ne serait donné que si les cartes avaient subi une évaluation selon les Critères Communs certifiée par le SCSSI.

Cette décision a eu plusieurs conséquences :

Elle a permis le développement d'une expertise dans le domaine de la sécurité des composants et des cartes, en France tout d'abord, puis en Allemagne (gros fournisseur de composants pour les applications bancaires) et en Hollande. La reconnaissance de cette expertise a largement dépassé le cadre européen.

Elle a poussée vers le haut le niveau de sécurité des autres applications (signature électronique, identité, passeport, etc.) à l’exception notable (du fait du volume de cartes émises) des cartes SIM pour lesquels les enjeux ne nécessitait pas de tels niveau de sécurité. A noter cependant qu'à partir de 2009, en France, cette situation a évolué puisque certaines cartes SIM ont été certifiées au même niveau que les cartes bancaires lorsqu’elles ont commencé à intégrer une application bancaire.

La certification sécuritaire est devenue un sésame pour l'export en dehors de l'Europe, certains pays non européen demandant explicitement des cartes certifiées en Europe.

EMVco, l’organisation qui maintien les standards pour les cartes de paiement, a imposé une évaluation inspirée de celle qui a été proposée en France pour les cartes bancaires. Le résultat paradoxal est qu’en 2015, les cartes françaises continuaient à être évaluées selon la norme internationale des Critères Communs et certifiées par l’ANSSI « par exception » tandis que le reste du monde utilisait des cartes évaluées selon les standards EMVco (il faut le reconnaitre, avec un niveau de confiance moindre cependant).

Quelques mots sur les évaluations et les certifications sécurité de produits

L'évaluation de la sécurité d'un produit consiste à vérifier que ce produit est conforme à un référentiel d'exigences. Cette évaluation est réalisée par un laboratoire d'évaluation. Celui-ci peut lui-même être conforme à une norme internationales (typiquement, ISO17025) qui garantie en particulier

- la constance (répétabilité) : l'évaluation répétée d'une même cible d'évaluation (TOE) vis-à-vis de la même cible de sécurité par le même laboratoire d'évaluation doit conduire au même verdict.

- la reproductibilité : l'évaluation répétée d'une même cible d'évaluation vis-à-vis de la même cible de sécurité par un laboratoire d'évaluation différent doit conduire au même verdict,

- l'impartialité : l'évaluation doit être exempte de biais,

- l'objectivité : l'interprétation du résultat d'un test ou d'une mesure doit être fait avec le minimum de jugement ou d'avis subjectif.

La conformité à cette norme fait l'objet d'une accréditation par un organisme autorisé, en France le COFRAC.

A noter que ces principes sont applicables à quasiment tous les domaines sauf... à la sécurité, ou du moins, la partie intéressante d'une évaluation sécuritaire, à savoir, l'analyse de la vulnérabilité des produits (recherche des failles de sécurité).

En effet, cette analyse fait intervenir une part d'expertise qu'il n'est pas possible de cadrer entièrement du fait de sa subjectivité, sauf à faire perdre tout intérêt à l'évaluation.

C'est pourquoi, afin d'offrir un certain niveau de garantie concernant ce point, il est nécessaire qu'un acteur soit présent dans le processus pour s'assurer que les analyses faites par les laboratoires d'évaluation sont bien au niveau de l'état de l'art.

Dans la plupart des pays, ce sont des agences gouvernementales qui assument généralement cette fonction. En France, il s'agit de l'Agence Nationale de la Sécurité des Systèmes d'Information (ANSSI). Ces agences sont également les centres de certifications et les certificats délivrés permettent d'avoir l'assurance que :

- l'évaluation a été réalisée conformément aux normes en vigueur ;

- l'analyse de vulnérabilité a été faite à l'état de l'art dans le domaine. A noter qu'en France, du fait des spécificités del a sécurité, l'analyse de vulnérabilité n'est donc pas couverte par l'accréditation des laboratoires d'évaluation par le COFRAC mais par l'agrément délivré par l'ANSSI aux laboratoires. Les laboratoires sont donc sous une double tutelle.

Pourquoi pas le secteur privé ? Théoriquement, rien ne s'y oppose. Mais jusqu'en 2021, il n'était généralement pas possible pour le secteur privé de rentabiliser ce type de certification. Les centres de certifications auraient du maintenir un pool d'experts dont le coût se serait forcément répercuté sur le coût de la certification rendant celle-ci insupportable pour les industriels.

Même un organisme comme EMVco qui « approuve » (notez le terme retenu, on ne parle pas de certification) les composants pour le domaine bancaire sous l'angle de la sécurité s'appuie en pratique sur des laboratoires d'évaluation dont les compétences sont vérifiées par d'autres qu'eux (du moins en Europe où les exigences sécurité sont plus élevées que sur d'autres continents).

Mais cette approche n'est pas partagée par tous. Ainsi, aux États-Unis, l'aspect subjectif de l'analyse de vulnérabilité est contesté. Et c’est ainsi que dans le domaine de l’évaluation logiciel, l’approche proposée (imposée) par les États-Unis est une analyse de vulnérabilité complètement objective basée sur une liste de vulnérabilités connues. Cette approche, si elle est parfaitement compatible avec les règles régissant les laboratoires d’évaluation, ne convainc pas les experts en sécurité.

Critères d'évaluation utilisés

Dans le domaine des cartes, les Critères Communs (CC) sont utilisés depuis les années 2000 en remplacement des critères européens ITSEC. L'évaluation des cartes et des composants est d'ailleurs un des rares domaines où ces critères ont eu un réel succès.

Il serait fastidieux d'entrer dans les détails des CC dans ce cours. Je me contenterai de décrire les quelques éléments que le lecteur doit avoir en tête :

- Les CC définissent une échelle de 7 niveaux de confiance pour une évaluation (EAL1 à EAL7, EAL pour Evaluation Assurance Level). Pour les cartes, le niveau minimum visé est le plus souvent EAL4 avec des augmentations.

- La principale augmentation est le niveau de résistance aux attaques (en fait, le niveau d'analyse de vulnérabilité). Il y a 5 niveaux (AVA_VAN.1 à AVA_VAN.5). Le niveau retenu pour les cartes est généralement AVA_VAN.5 (résistance élevée aux attaques).

- L'évaluation vérifie la conformité du produit par rapport à une cible de sécurité qui peut être assimilé à une expression de besoin en sécurité. Cette cible spécifie ce qui doit être évalué et à quel niveau de confiance. Dans le domaine des cartes, il existe des cible de sécurité génériques (des profils de protection) universellement adoptées qui garantissent que toutes les évaluations se font selon les mêmes exigences.

- Les certificats délivrés par les organismes de certification bénéficient d'une reconnaissance internationale grâce à deux accords :

- L'accord international dit CCRA. Dans cet accord, la reconnaissance est limitée au niveau EAL2 des CC.

- L'accord européen dit SOGIS. Dans cet accord, la reconnaissance se fait au plus haut niveau des CC sous réserve que les organismes de certification et les laboratoires qui en dépendent soient compétents dans le domaine technique. En 2020, Les pays en mesure de certifier les cartes à haut-niveau de confiance étaient la France, Le Royaume-uni, les Pays-bas, l'Allemagne, l'Espagne.

En conséquence, seules les évaluations sécurité de cartes faites en Europe sont reconnues par les Européens et en pratique, la notoriété de l'accord SOGIS est telle que pendant de nombreuses années, des pays en dehors de l'Europe demandaient que leurs cartes soient évaluées et certifiées en Europe au sein de cet accord. Depuis les années 2010, certains de ces pays cherchent également à monter des schémas d'évaluation et de certification similaires.

Une des raisons de ce succès vient sans doute du fait que dès les années 2000, le monde de la sécurité des cartes (industriels, laboratoires, agences gouvernementales, grands utilisateurs) a accepté de travailler en commun sur les attaques au sein d'un groupe de travail, le JHAS (Joint Interpretation Library - Hardware Attack Subgroup). Les résultats de ce groupe de travail ont servi de référence pour tous les laboratoires européens réalisant des évaluations CC et par la suite, EMVco.

Les document produits par le JHAS ne sont pas publics. Par contre, le document public Application of Attack Potential to Smartcards donne quelques idées sur les moyens employés par les laboratoires pour évaluer les composants et les cartes. Pour plus de précisions, voir le chapitre Sécurité du composant matériel.

Particularités de la sécurité des cartes

Les travaux sur l'évaluation de la sécurité des produits selon des critères normalisés et ouverts ont démarré en France dans les années 1990. Assez rapidement, il est apparu que les cartes présentaient des particularités qui ont été théorisées et explicitées dans des documents parus sous l’égide du SOGIS et qui ont ensuite été repris au niveau international via le CCRA.

Pour les lecteurs pressés, voici un résumé de ces particularités :

- La plus importante est que les cartes sont les seuls produits qui peuvent être évaluées sans faire d’hypothèse sur l’environnement d’utilisation.

- Les utilisateurs sont de confiance

- L’environnement d’utilisation est protégé

- Le système support (typiquement, le système d’exploitation) est correctement administré (et parfois, de confiance « a priori »)

- Le matériel est de confiance (processeur, circuits auxiliaires (chipsets)…)

- Etc.

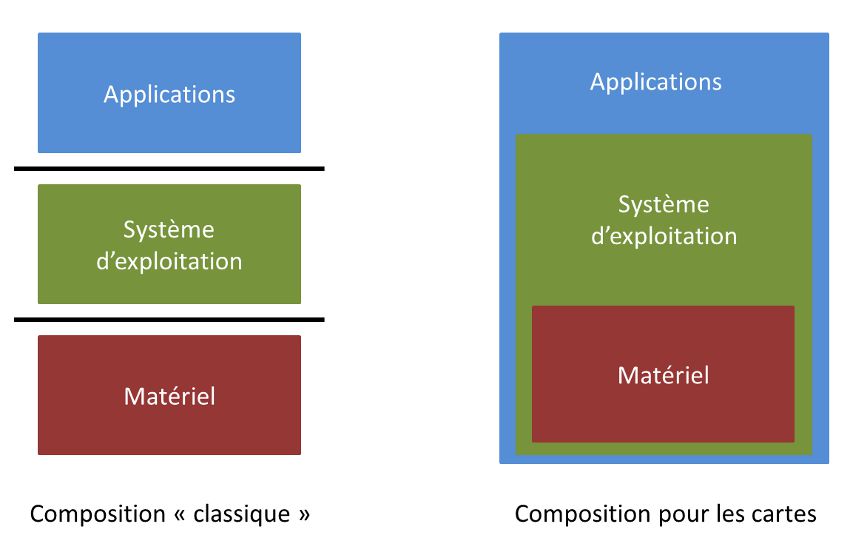

- Le mécanisme de composition est spécifique (voir Composite product evaluation for Smart Cards and similar devices) Comme le terme de « composition » n’est pas forcément clair pour tout le monde, voici une illustration :

- Pour couronner le tout, les évaluations cartes utilisent une cotation des attaques propre au domaine. Ce n’est pas sans entrainer une certaine confusion qui profite à certains... Ce qu’il faut savoir, c’est qu’un ELA4+AVA_VAN.5 pour une carte est d’un niveau de résistance aux attaques sans commune mesure avec une cotation identique pour les autres types de produits.

Lorsqu’on évalue la sécurité d’un produit informatique habituel (pare-feu, système d’exploitation, produit de signature, HSM, etc.), il y a toujours des hypothèses simplificatrices qui permettent d’éliminer certaines attaques. Exemple :

Pour une carte dans le mode « émis » (le mode dans lequel la carte est fournie à son utilisateur), il n’y a le plus souvent aucune hypothèse simplificatrice. L’évaluateur a donc la possibilité de faire toutes les attaques qui lui viennent en tête dès lors qu’elles sont susceptibles de compromettre un bien sensible identifié dans la cible de sécurité.

Considérons un pare-feu personnel s’exécutant sur un poste de travail dont l’éditeur demande l’évaluation. La cible de sécurité du produit décrira les fonctionnalités techniques du pare-feu à prendre en compte durant l’évaluation et décrira sous forme d’hypothèses ce qui est attendu de la part du système d’exploitation.

Dans un monde idéal, on peut supposer qu’il existe un système d’exploitation évalué et certifié sur lequel peut s’exécuter le pare-feu. L’évaluateur vérifiera alors que les hypothèses de la cible de sécurité du pare-feu sont cohérentes avec celles du système d’exploitation et que les fonctionnalités du système d’exploitation sur lesquelles s’appuie le pare-feu sont utilisées correctement. S’étant assuré de ces points, l’évaluateur éliminera toutes les attaques qui sont susceptibles d’être couvertes par des fonctions évaluées du système d’exploitation ou par les hypothèses et concentrera son effort sur les seules fonctionnalités du pare-feu (en pratique, c’est un peu plus compliqué mais c’est l’idée).

Cette approche permet de construire des systèmes complexes dont chaque couche apporte à l’autre certaines fonctionnalités évaluées une fois pour toute et que l’on ne remet pus en question, sauf évolution de l’état de l’art dans le domaine des attaques (en pratique, en 2021, on est loin de cette situation).

Dans le domaine des cartes, il est apparu assez rapidement que cette approche ne fonctionnait pas. Et pour ne pas l’avoir compris, certains industriels ont pu faire des cartes très facilement attaquables alors même que le composant était évalué et certifié au plus niveau et le logiciel qui s’exécutait dessus également.

Il y a des raisons techniques à cela, à commencer par le fait qu’aucun composant ne peut résister à toutes les attaques sans que le logiciel (système d’exploitation ou application) implémentent des contre-mesures spécifiques. Ces contre-mesures ne peuvent pas toutes être spécifiées par le fabricant du composant sauf en des termes généraux. La certification d’une carte (partie applicative) est donc toujours associée à un composant particulier (évalué et certifié) et à un système d’exploitation particulier lorsqu’il y en a un (évalué et certifié sur le composant en question).

Lors de l’évaluation de l’application, l’évaluateur doit être en mesure de réaliser certains tests sur les éléments sous-jacents. Pour ce faire, il dispose d’un rapport spécifique (ETR for composite evaluation) lui permettant de disposer d’informations issues des évaluations des éléments sous-jacents.

Conclusions

Même si depuis que les cartes bancaires existent et ont popularisé le concept, peu de personnes, y compris chez les experts en sécurité, connaissent et comprennent les particularités de cet objet du point de vue de la sécurité.

Les rares attaques publiées concernent des cartes pour lesquelles il n'y a pas eu d'effort particulier du point de vue de la sécurité.

Par ailleurs, il y a souvent confusion entre les attaques portant sur les cartes et celles portant sur le système : ce n'est pas parce qu'une carte résiste à des hauts niveaux d'attaque qu'elle est correctement utilisée ou pire, paramétrée par les émetteurs. Les exemples d'attaques qui n'en sont pas au début de ce chapitre illustrent ce point.

Enfin, pour les quelques experts qui s'intéressent au sujet, la carte représente un défi intéressant et des techniques d'attaques de très haut niveau font donc l'objet de publications dans différente conférences. Mais souvent, celles-ci portent sur des cartes anciennes ou qui ne sont pas réellement de « haute-sécurité ».

Et de fait, les cartes « haute-sécurité » représentent une partie assez faible du marché. Pour faire simple, ce sont généralement :

- Des cartes bancaires.

- Des cartes pour télévision à péage.

- Des cartes pour l'administration électronique (identité, passeport...)

- Quelques rares cartes SIM en France

- Quelques cartes de contrôle d'accès logique.

L'immense majorité des cartes (cartes SIM, cartes pour le transport par exemple) ne méritent pas le qualificatif de « haute-sécurité ». Parfois pour de bonnes raisons : l'environnement d'utilisation ou les enjeux ne nécessitent pas de faire des efforts particuliers vis-a-vis de la sécurité ; parfois pour de mauvaises raisons, l'ignorance n'étant pas la moindre.

La recherche d'un haut niveau de sécurité aura permis pendant un temps à l'Europe de briller dans un des domaines de la sécurité (probablement le seul) et de développer des industries devenue des références internationales (fabricants, laboratoires...). Il est probable que cette position ne durera plus très longtemps (2021), en particulier grâce aux efforts constants de la commission européenne depuis 2014 pour tuer l'écosystème qui s'appuyait sur le SOGIS. C'est chose faite depuis 2019 (voir le réglement 2019/881) [archive] qui, s'il présente bien (comme la plupart des textes officiels), signe en pratique la fin des évaluations commerciales ayant un minimum de sérieux.

La fluidification des échanges s'accommode mal des contraintes liées à la recherche d'un certain niveau de sécurité, d'autant plus que beaucoup d'industriels en Europe ne sont pas à niveau. Plutôt que d'augmenter le niveau de performance des produits, on modifie la façon de mesurer. En clair, on tire vers le bas (voir le « niveau élémentaire » dans le réglement, en pratique, celui qui s'appliquera pour la majorité des produits).

Ce n'est pas la première fois que la commission européenne procède de cette façon et ce n'est sans doute pas la dernière. Mais dans le cas présent, je pense que ni les USA, ni la Chine n'en demandaient tant !

Sécurité du composant matériel

Pour les cartes « haute-sécurité », l'objectif des fondeurs (ou plus justement des concepteurs de composant puisqu'il faut également considérer les fabless, c'est à dire, des concepteurs de composants ne disposant pas de fonderies) est de proposer un composant qui offre un maximum de contre-mesures par rapport aux attaques connues et si possible, qui permettent au développeur de masque de s'affranchir des préoccupations liées aux attaques sur le matériel pour ne se consacrer qu'aux fonctionnalités. Même si l'on « tend vers », cet objectif n'est toujours pas atteint en 2021. Néanmoins, les fondeurs améliorent leur produits en permanence et les avancées faites depuis les années 2000 ont été considérables, il faut bien le dire, en grande partie grâce aux exigences sécurité du marché bancaire français (ce qui est encore une fois paradoxalement peu connu en France).